《英国医学期刊》的研究人员警告称,许多声称人工智能和(或更好)人类专家解读医学图像的研究质量低下,而且可以说是被夸大了,给“数百万患者”的安全带来了风险。他们的研究结果引起了人们对许多这些研究所依据的证据的质量的关切,并强调需要改善其设计和报告标准。

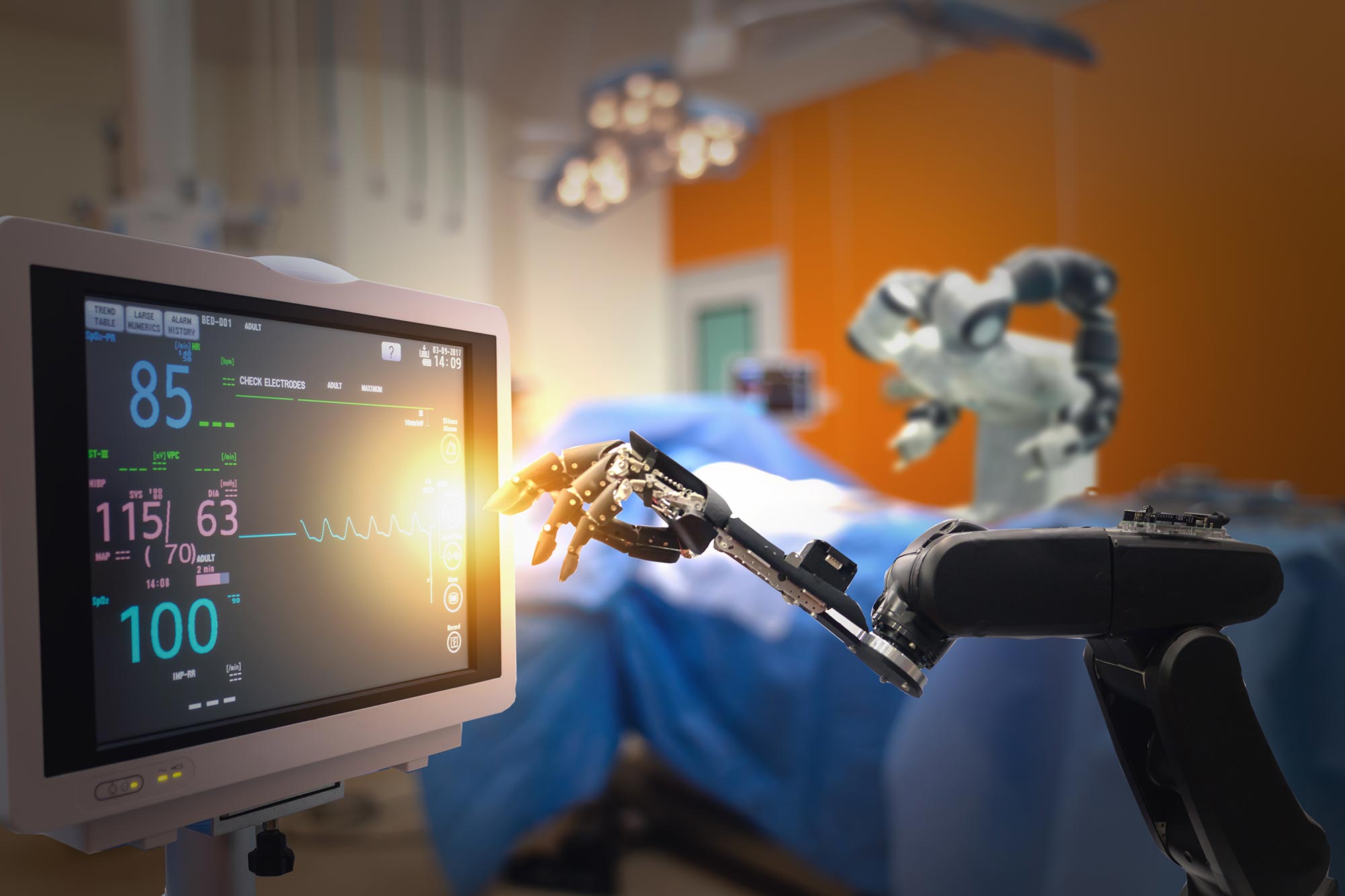

人工智能(AI)是一个创新和快速发展的领域,有潜力改善病人护理和减轻负担过重的卫生服务。深度学习是人工智能的一个分支,在医学成像领域表现出了特别的前景。

已经发表的关于深度学习的研究数量在不断增长,一些媒体头条声称AI的表现优于医生,这助长了炒作。但是,这些标题背后的研究方法和偏倚风险还没有得到详细的检验。为了解决这个问题,一组研究人员回顾了过去10年发表的研究结果,并将深度学习算法在医学成像方面的表现与临床专家进行了比较。

他们发现只有两项符合条件的随机临床试验和81项非随机研究。在非随机的研究中,只有9项是前瞻性的(随着时间的推移跟踪和收集个人信息),只有6项是在“真实世界”的临床环境中测试的。

比较国组的人类专家的平均人数只有4人,而获取原始数据和代码(以便对结果进行独立审查)的能力受到严重限制。

超过三分之二(81项中的58项)的研究被判定有较高的偏倚风险(研究设计中可能影响结果的问题),遵守公认的报告标准的情况往往较差。四分之三(61项研究)的研究表明人工智能的表现至少与临床医生相当(或更好),只有31(38%)的研究表明需要进一步的前瞻性研究或试验。

研究人员指出了一些局限性,例如可能错过研究,以及关注深度学习医学成像研究,因此结果可能不适用于其他类型的人工智能。

尽管如此,他们说,目前“存在着许多关于与临床医生等价(或优于临床医生)的夸大说法,这在社会层面上对患者安全和人口健康构成了潜在风险。”

他们警告说,过分承诺的语言“使研究容易被媒体和公众曲解,结果可能提供不适当的护理,不一定符合患者的最佳利益”。总结道:“最大限度地保障患者的安全,最好的办法是确保我们开发出高质量和透明报告的证据基础。”

赞(0)

赞(0)

粤公网安备 44030502004540号

粤公网安备 44030502004540号