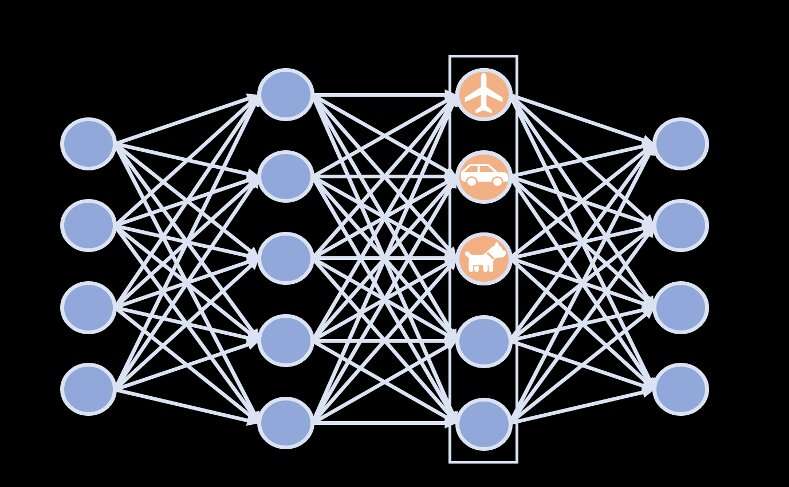

在过去十年左右的时间里,深厚的神经网络在各种任务,包括图像识别任务方面取得了非常有希望的成果。这些网络尽管有其优势,但非常复杂和复杂,因此很难或有时不可能解释它们学到的知识并确定预测背后的过程。这种缺乏解释性的情况使得深层神经网络在某种程度上不可信任和不可靠。

杜克大学(Duke University)预测分析实验室(Prediction Analysis Lab)的研究人员由辛西娅·鲁丁(Cynthia Rudin)教授领导,他们最近设计了一种技术,可以提高深神经网络的可释性。这种称为"白概念"的方法最初是在《自然机器情报》上发表的一篇论文中提出的。

开展这项研究的研究人员之一齐·陈(Zhi Chen)对Tech Xplore说, “我们没有进行事后特别分析,以观察NN的隐藏层,而是直接改变NN ,解开潜在的空间,使轴与已知的概念保持一致。 ”"这种脱节可使我们更清楚地了解网络如何逐层逐渐学习概念。它还将关于一个概念(例如"灯泡" 、 "床"或"人")的所有信息集中在一个神经元上;这就是分心的含义" 。

起初,鲁丁和她的同事设计的技术解开了神经网络的潜在空间,使其轴与已知的概念相一致。从本质上讲,它是一种"白炽化的转变" ,类似于信号转化为白噪音的方式。这种转变与潜在空间有关。随后,轮调矩阵在战略上将不同的概念与轴相匹配,但不扭转这种关系。

陆克文解释说, “ CW可以应用于NN的任何一层,以获得可释性,同时又不损害模型的预测性能。 ”“从这个意义上讲,我们几乎不做什么努力就能做到解释,我们不会因为黑匣子而失去准确性。 ”

新办法可用于提高用于图像识别的深神经网络的可解释性,但不影响其性能和准确性。此外,它不需要广泛的计算能力,这样就更容易在各种模型中使用和使用更广泛的装置。

“通过在网络的早期层面沿着轴线看,我们还可以看到它是如何制造概念抽象的, ”陈士争说。"例如,在第二层,飞机看起来是蓝色背景下的灰色物体(有意思的是,这可能包括海洋生物的照片)。神经网络在第二层没有多少表现力,因此,了解它如何在第二层表达一个复杂的概念,如"飞机" ,是很有意思的" 。

这一概念不久将使深度学习领域的研究人员能够对他们正在开发的模型进行故障排除,并更好地了解模型预测背后的过程是否可以信任。此外,提高深度神经网络的可判读性有助于揭示培训数据集方面可能存在的问题,使开发人员能够解决这些问题,并进一步提高模型的可靠性。

“未来,我们计划不再依赖预先确定的概念,而是从数据集中发现一些概念,特别是尚未发现的有用的、未界定的概念, ”陈说。"这将使我们能够以分崩离析的方式,在神经网络的潜在空间中明确代表这些已发现的概念,以提高可解释性" 。

赞(0)

赞(0)

粤公网安备 44030502004540号

粤公网安备 44030502004540号