欢迎来到人工智能与机器人产业平台!

登录

智迎未来:

搜索

数据资产登记

从单词接龙到行业落地

时间:2025-05-12 来源:

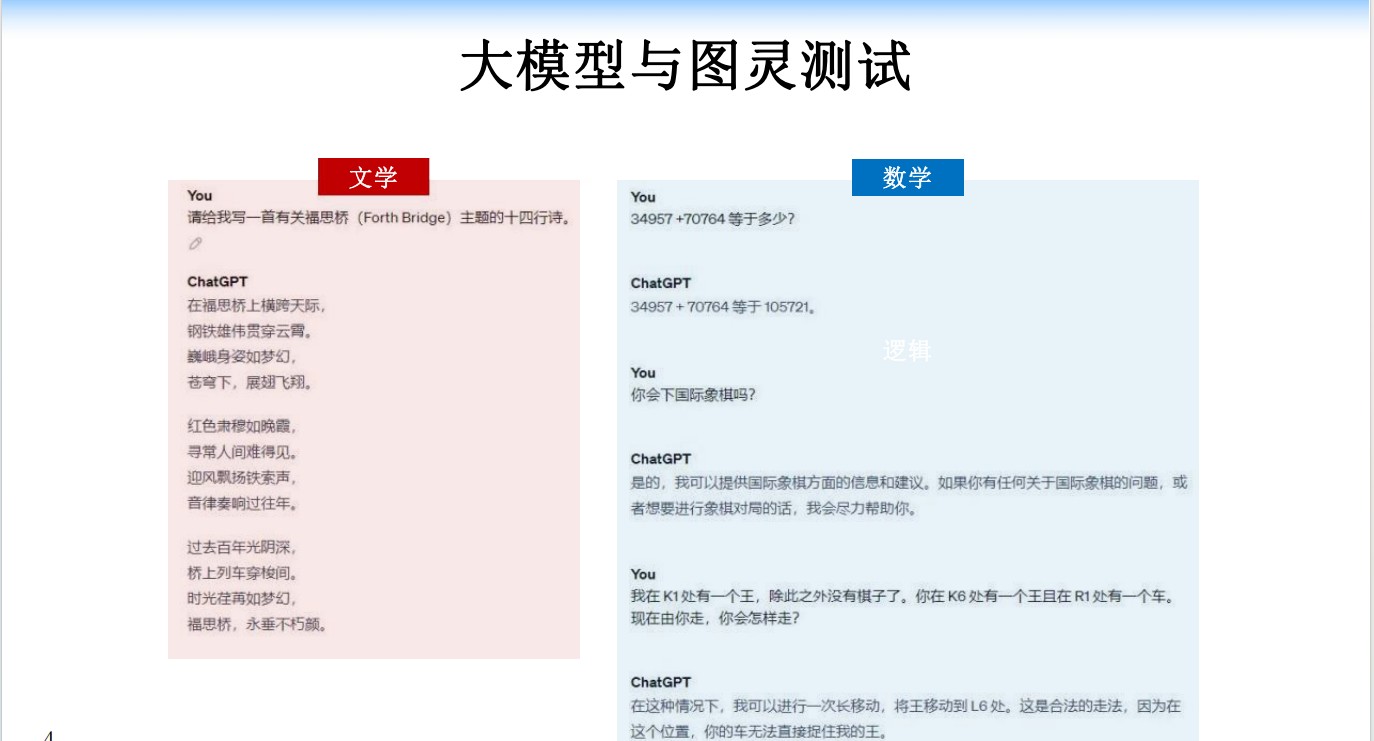

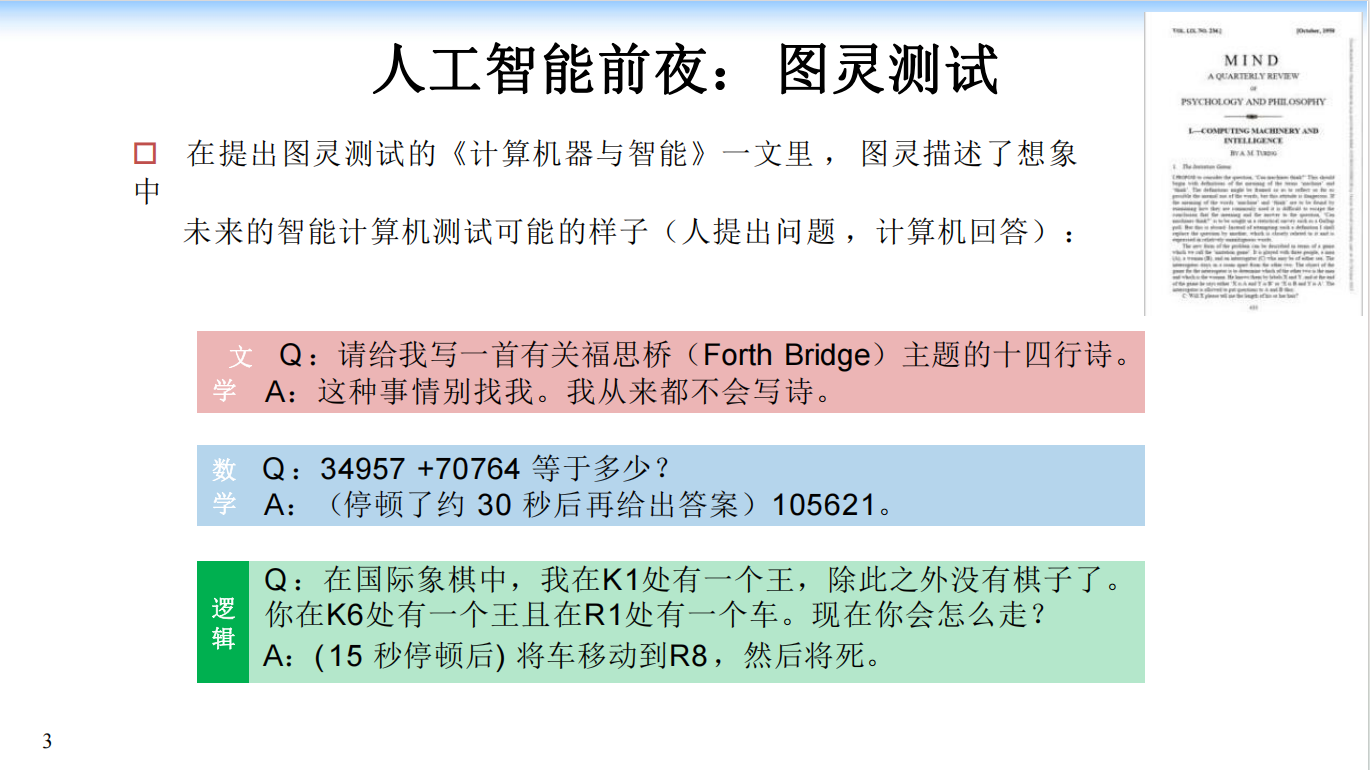

大语言模型(LLM)通过单词接龙的方式生成文本,利用Transformer架构计算条件概率,实现自然语言处理任务。

预训练阶段,LLM从海量无标注数据中学习,掌握物理世界知识和人类语言模式。微调阶段,通过监督微调(SFT)

和指令微调(Instruction Tuning),优化模型在特定任务上的性能。针对幻觉、偏见和过时信息等问题,检索增

强生成(RAG)通过外部数据库补充知识,提升模型的可解释性和信息及时性。

LLM在智慧评审、癫痫预测等领域的应用,展示了其强大的行业落地能力。

下载完整内容

声明:本文内容仅代表作者个人观点,本站只提供参考不构成任何投资及应用建议,转载请注明来源

赞(0)

赞(0)标签

相关报告

北大推出全新机器人多模态大模型!面向通用和机器人场景的高效推理和操作

北大领衔,多智能体强化学习研究登上Nature子刊

ICLR 2025 | Diffusion Planner: 基于扩散模型的自动驾驶规划算法,nuPlan SOTA!

Meta开源分子数据集OMol25、原子通用模型UMA,加速分子、材料、神经科学进展

库萨科技如何用智能机器人革新城市服务

墨现传感器机器人“电子皮肤”,搭载闪电匣 Arm全球首款商用类人形机器人发

普渡发布首款类人形机器人,开启服务机器人行业新篇章

云深处科技:绝影X30四足机器人亮相

粤公网安备 44030502004540号

粤公网安备 44030502004540号